ROC/AUCカーブ

この記事では、ROC/AUCカーブと、それを訓練済みモデルのパフォーマンス測定として使用する方法について説明します。

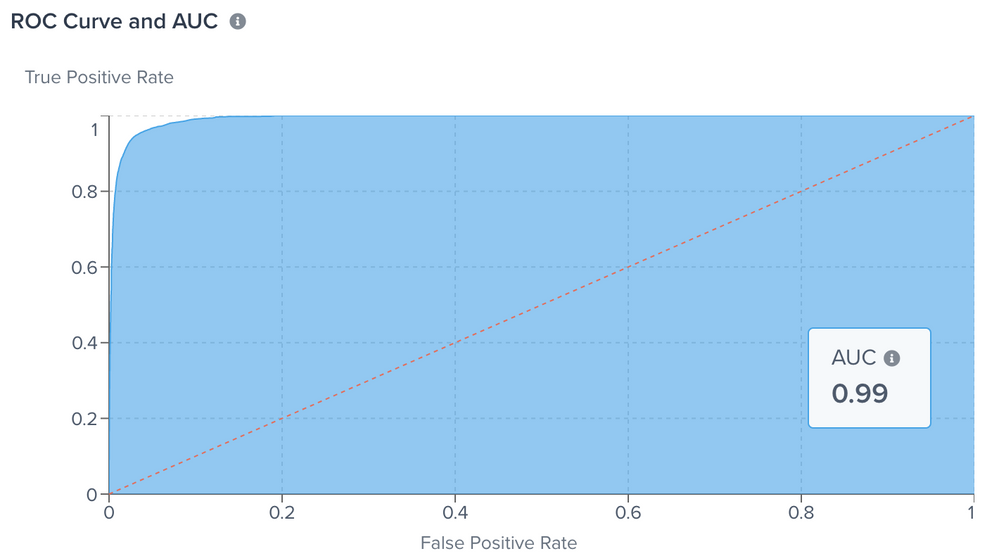

Tealium Predictでは、ROC/AUC(カーブ下)は、モデルエクスプローラーで訓練済みモデルのパフォーマンス測定として報告されます。業界用語では、_ROC_は真の陽性率で、真の陽性数を真の陽性数と偽陰性数の合計で割ったものです。ROCは、実際の結果が陽性の場合にモデルが陽性クラスをどれだけよく予測するかを説明します。真の陽性率はまた、_感度_とも呼ばれます。訓練済みモデルのROC/AUCカーブにアクセスするには、モデルダッシュボード>モデル詳細を表示>トレーニング>トレーニング詳細を表示に移動します。

受信者操作特性(ROC)カーブとこのカーブの下の領域(AUC、カーブ下面積と呼ばれる)は、分類モデルのパフォーマンスを評価するための機械学習コミュニティで一般的なツールです。

ROCカーブは、異なる閾値間のトレードオフを示し、真の陽性率(y軸)を偽陽性率(x軸)に対してプロットしたものです。以下の通りです:

- 真の陽性率 = 感度

- 偽陽性率 = (1 - 特異度)

理想的には、結果は真と偽のクラスを区別することができます。モデルは常に正しい答えを予測します。

ROCの例

以下の例は、確率分布とROCカーブの「完璧なモデル」を示しています:

- 上記のROCカーブでは、AUC = 1です。グラフ全体の領域は赤いカーブ(境界)の下と右に表示されます。

極端な対比として、以下の例は、モデルが常に間違った答えを予測するシナリオ、例えば常に真を偽とラベリングする場合の確率分布とROCカーブを示しています。

- このROCカーブでは、AUC = 0です。

以下の例は、真と偽のクラスを区別できないモデルと定義される貧弱なシナリオを示しています。このシナリオでは、確率分布は2つの大きなカーブが直接重なって表示されます。

- ROCカーフは対角線で、AUC = 0.5です。

現実的なROCカーブでは、0.5 < AUC < 1.0は、プロットのx軸に小さい値を表示して偽陽性を低くし、真陰性を高くします。大きな値はプロットのy軸に表示され、真の陽性を高くし、偽の陰性を低くします。

二値の結果を予測するとき、それは正しい予測(真の陽性)かそうでない(偽の陽性)です。

最終更新日 :: 2024年March月29日